まず初めに、このブログを読んだいただくと下記の要点を理解できます。

- アクセスログ解析の意義

- テクニカルSEO観点から考えるアクセスログ解析の有用性

- アクセスログ解析の応用

ここ最近クライアント様において、「Webサーバーに記録されたログ情報(主にGoogleクロール)を分析し、SEO課題の発掘を試みる」という取り組みを行っています。

私自身、前職でもサーバー上にある生ログデータを分析するという経験をしたことがなかったため、今回、アクセスログを解析することによるテクニカルSEOの有用性について解説して参ります。

余談ですが、筆者は2022年2月15日にアクセスログ解析をテーマとしたセミナーにも登壇しました。

»Google Search Consoleの次なる一手 – アクセスログ解析による新たなSEO課題の発見

生ログの実体とは

皆さんは「生ログ」というデータ群を見たことがあるでしょうか?

生ログデータとは、「ウェブサーバーやネットワーク機器、OS(オペレーションシステム)などへの接続や操作の履歴を、時系列ベースで記録したファイル」のことを指します。

従来、アクセスログはサイト障害の原因究明に役立つもので、システムの安定した運用や保守、管理のためには欠かせないデータです。実際にサイト障害が発生した際に、その直前で何か起きていたのかをログデータを辿ることで明らかになり、同じことが起きないように傾向の把握や対策に活かすことができます。

ログデータの形式

アクセスログはウェブサーバーの種類(ApacheやNginx、ISSなど)によって出力形式が異なります。

またHTTPやPHPファイルへアクセスした記録のほかに、CSSやJPG画像などといったコンテンツを構成する全てのファイルが記録されます。従って、通常はブラウザからの1回のアクセスで複数行のログデータが記録されることが一般的です。

ログデータの例

ログデータの一例として、下記は弊社コーポレートサイトで実際に記録されたものです。

www.principle-c.com xx.xx.xx.xx – – [28/Jan/2022:00:59:26 +0900] “GET /column/global- marketing/youtube_big_brand/ HTTP/1.1” 200 21127 “https://www.google.co.jp/” “Mozilla/5.0 (iPhone; CPU iPhone OS 11_0_2 like Mac OS X) AppleWebKit/604.1.38 (KHTML, like Gecko) Version/11.0 Mobile/15A421 Safari/604.1”

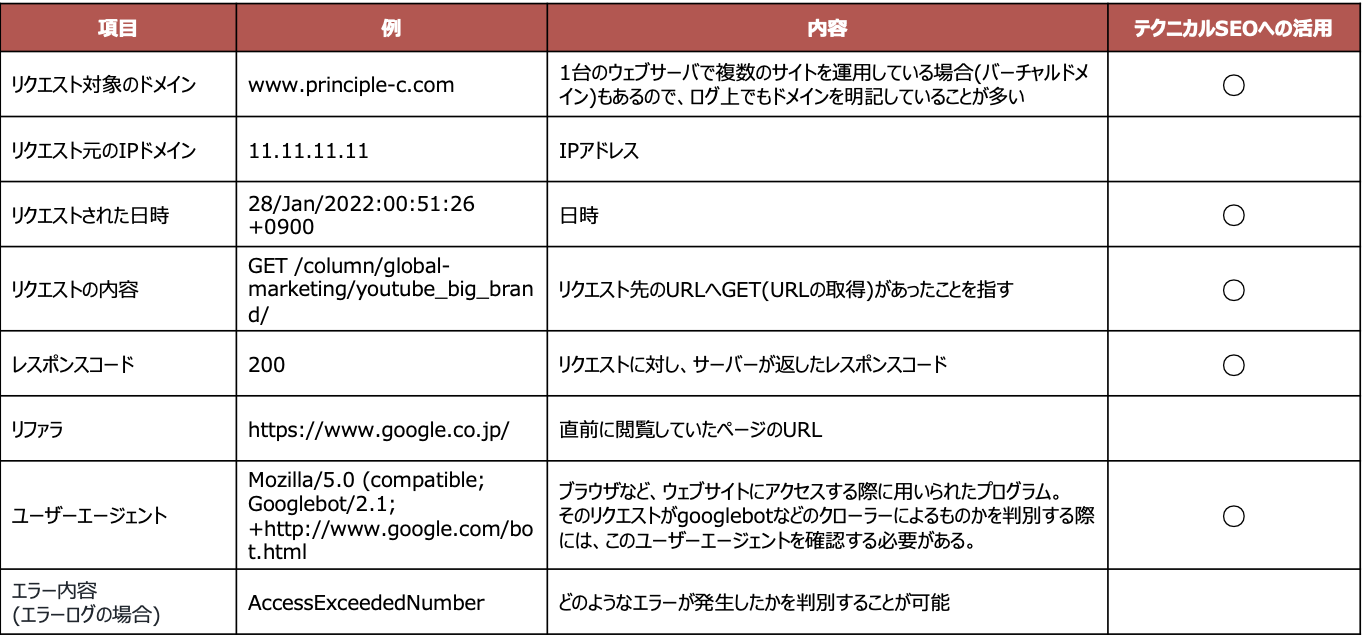

では、上記のアクセスログにはどのようなデータが記録されているのでしょうか?表を作成してみました。

テクニカルSEOへ活用できる項目としては、下記が考えられます。

- リクエスト対象のドメイン

- リクエストされた日時

- リクエスト内容

- レスポンスコード

- ユーザーエージェント(Googlebotの判別に利用)

など。

つまり、アクセスログからクロール関連情報(Googlebotなど)を抽出・分析することで、SEOにとって有用な改善施策が見つかることが期待できる、という点が特徴的です。

加えて、SEOやデジタルマーケティングの観点から生ログを1行で要約するのであれば、「検索エンジンがWebサイトをどのようにクロールしているのか、唯一100%、正確なデータとして提供してくれる宝箱」であると解釈できます。

アクセスログ解析とSEOの有用性について

先ほど申し上げたように、アクセスログからクロール関連情報を抽出・分析することで、テクニカルSEOにとって有用な改善策を見つけることができます。

下記は実際にクライアント様と対峙する中で、どのような期待効果が得られるのかをまとめたものです。

特定のディレクトリやURLへのクロール頻度・回数を捕捉したい

→Google Search Consoleを用いれば、サイト全体のクロール数を知ることはできるが、ページグループ別やURL別などの細かい粒度では分析が困難である。しかしながら、ログ解析であれば網羅的な調査・分析が可能となる。

クロールバジェットの枯渇を防ぎたい

→クロール数の割り当ては有限であるため、「意図しないURLへクロールされていないか」などの分析に効果的。

特定の施策における効果検証

→特定の施策を実装した後、どの程度効果が出ているかをログデータを用いて定常モニタリングすることも可能。(例:インデックス率の悪いページ群に内部リンクを集約した際、施策前後のユニークURL数を分析)

サイト改修のバグ検知(応用)

→ログデータは日時(秒単位)で履歴が記録されているため、サイト改修時に5xxページが急増した場合、どの時点から増えたのかを特定できる。またクロールの平均処理時間などについても、時系列で取得・把握できる。

これらはほんの一部にすぎませんが、アクセスログを解析することでテクニカルSEOにとって有用な示唆出しが可能となり、更なるサイト改善を期待することができます。

Search Console「クロール統計情報」との違いについて

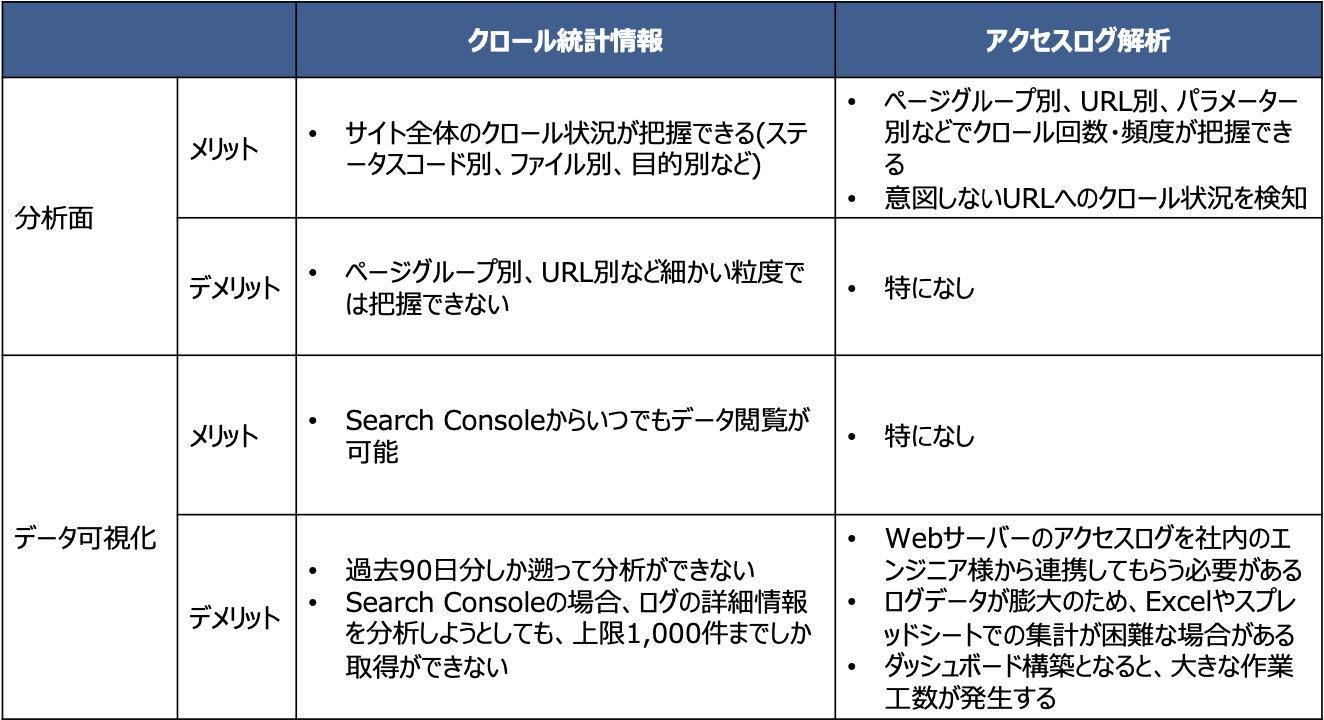

Google Search Consoleにはクロール統計情報という機能が備わっています。具体的には、サイト全体へどれぐらいのクロールが巡っているのかを理解できるだけではなく、「ステータスコード別」「ファイル別」「目的別」などのクロール情報も把握できます。

Google Search Consoleのクロール統計情報とアクセスログ解析を、分析の面とデータ可視化の面から比較しまとめたものが下表です。

このようにアクセスログ解析は細かい粒度での網羅的なクロール解析が可能です。一方で、社内連携やTableauなどのビジュアライズツールの導入といった工数も検討する必要があります。

弊社コーポレートサイトの生ログを分析してみた

今回、弊社コーポレートサイトの生ログをTableauで可視化してみました。

※ データ取得期間:2021年11月〜2022年2月8日

以下の3点についてまとめます。

- 各botのクロールボリューム

- ステータスコード別のクロール推移

- ページグループ別のクロール推移

各botのクロールボリューム

botごとのクロールボリュームを時系列で理解できます。例えば、Bing検索でサイトを発見してほしい場合、安定的にBingbotがサイトへ訪問しているかも把握することができます。

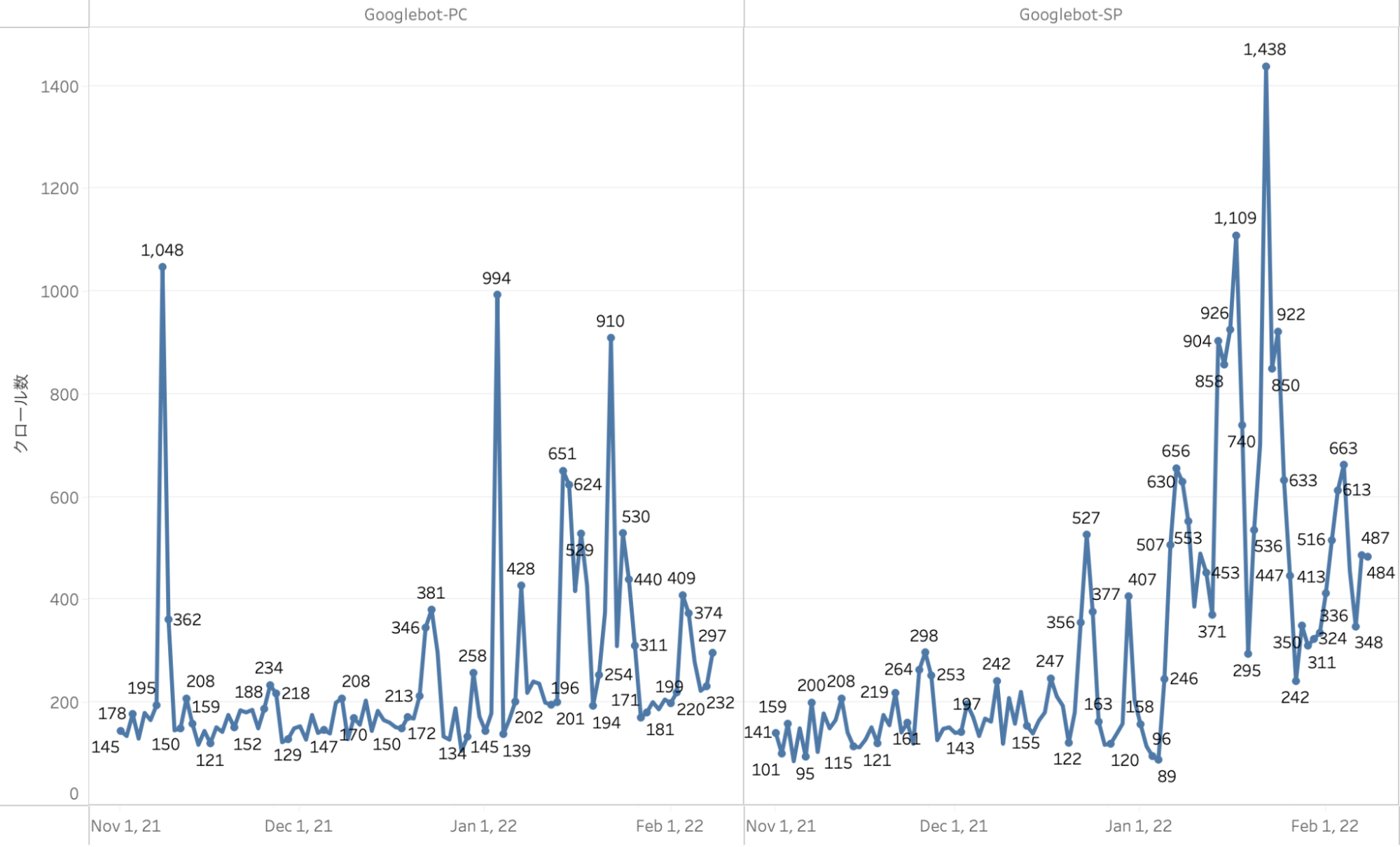

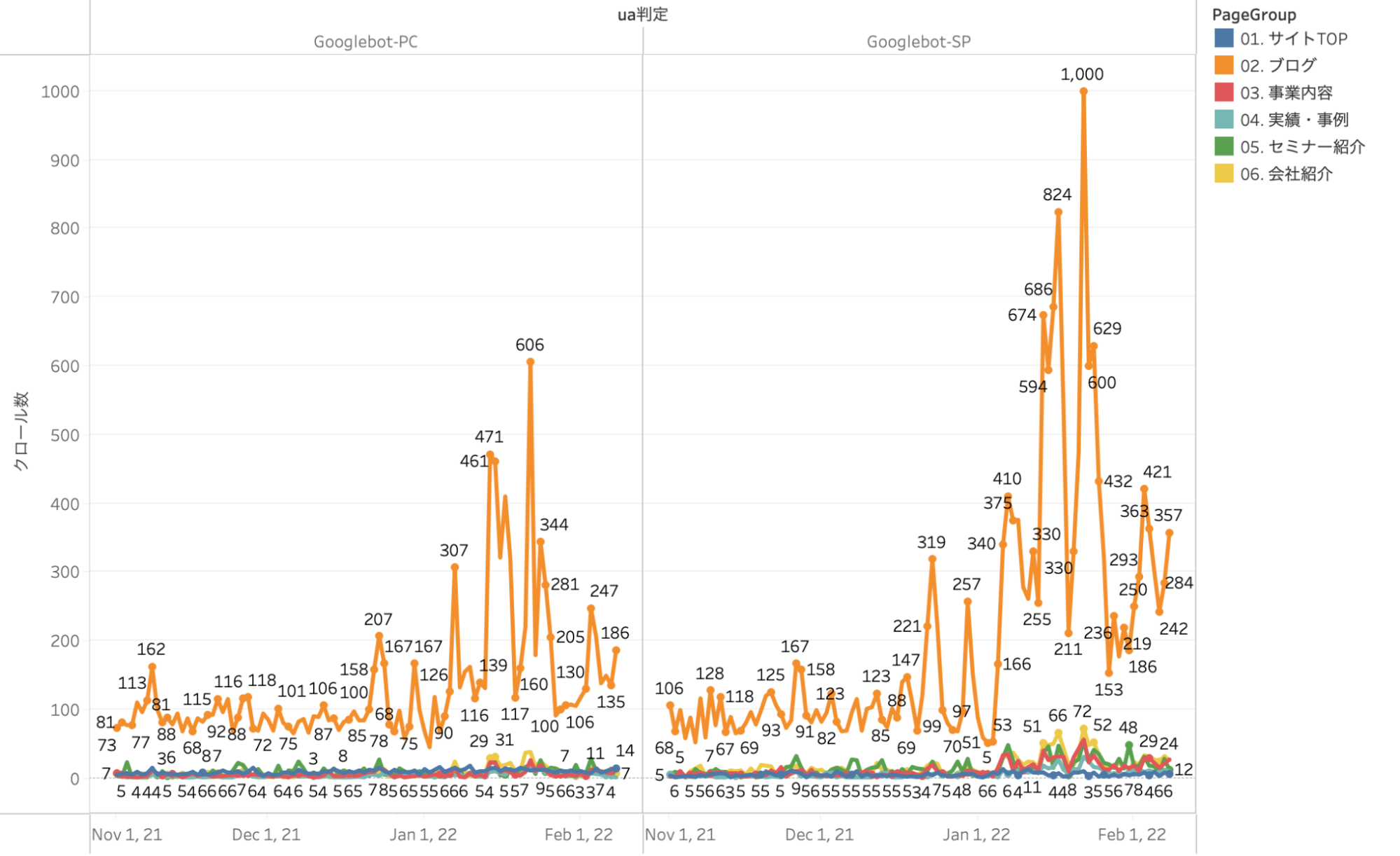

下記は、Googlebot-PCとGooglebot-SPのクロール数を時系列で可視化したものです。ほとんどのサイトはMFI(Mobile First Index)に移行していることから、Googlebot-SPの割合が多いことが分かります。

ステータスコード別のクロール推移

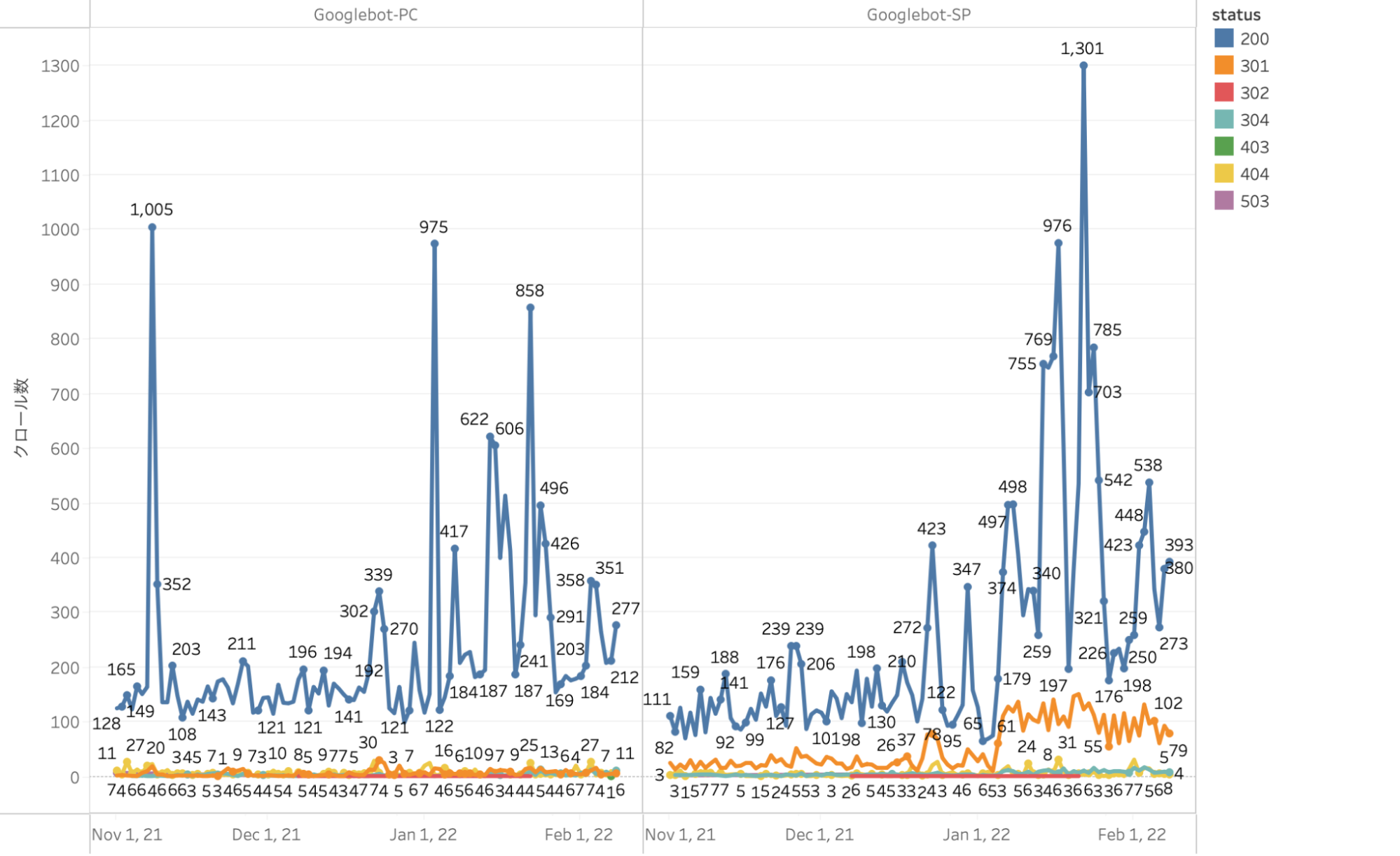

続いて、日別のクロールボリュームをステータスコード別に分析してみました。

弊社コーポレートサイトに限らず、200ステータスコードを返すURLがほとんどです。SEO評価に影響を与えるような4xxや5xxのURLがある一時点で急増している場合などには、注意が必要となります。

ページグループ別のクロール推移

分析にあたり、対象サイトを下記のページ群に定義しています。

- 01.サイトTOP

- 02.ブログ

- 03.事業内容

- 04.実績・事例

- 05.セミナー紹介

- 06.会社紹介

弊社サイトでは、「ブログページ」へクロールが多く巡回していることが理解できると思います。ページグループごとにクロール数を分析することで、クロールが行き届いていないグループを知ることも可能です。

その他の検証

- 平均処理時間や平均送信バイトのモニタリング

- アクセスログの自動化、早期バグ検知の体制整備

- ステータスコード別の網羅調査

など、本ブログでは転載することができないのですが、生ログを用いてさまざまな検証を日々行なっています。

まとめ

今回、読者の方へお伝えしたかった点は下記の3点です。

- アクセスログ解析は「サイトの健康診断(ヘルスチェック的な意味合い)」として運用することをお勧めします

- Google Search Consoleのクロール統計情報では制約が多い

- 別指標との相関を見出していく

生ログデータは膨大なビックデータであることから、実際の分析までに工数が発生することもあります。(社内連携やデータ可視化など)その反面、隠れたテクニカルSEO観点での課題を見つけることが期待できます。

特に大規模サイトではクロール統計情報では物足りないと感じる方もいらっしゃると思います。頻繁に生ログを解析するのは難しくても、定期的なサイトのヘルスチェックとして運用することで、有用な示唆・サイト改善が見込めると考えます。

これまで気付かなかった問題点や課題が必ずしも見つかるとは限りませんが、Search Consoleで報告されている以上の情報を入手したいのであれば、一度対応を検討することを推奨します。

最後となりますが、これからもGoogleクロールと真剣に向き合いながら、有益な方法を発信していければと思います。